지난 Part 3에 이어서 동일한 모델로 Case Study 사례를 분석해 보도록 하겠습니다. 앞으로 살펴볼 Load(부하)의 변동은 1) LLM Training, 2) Finetuning, 3) LLM Inferenence(추론) 까지 총 3가지 종류의 Work에서 보여주는 부하(Load) 변동성 입니다.

Case Study : LLM Traning

Case study를 위해서 NVIDIA, AMD 사의 GPU와 GPT-2 124M 과 nanoGPT 모델 두가지를 적용하여 Test를 진행 하였습니다.

1. NVIDIA RTX 4090 (w/ GPT-2 124M) _ 124M paramteters

a. 학습시간: 22시간

b. 전력 : 평균 414W (최대전력 461w)

large Power transients: 320w 급격한 감소(Drop), 350w 빠른 증가(Ramp)

c. 편차: 113.7w

2. ADM RX 7900 XTX (w/ nanoGPT) _ 27M parameters

a. 학습시간: 11시간

b. 전력: 평균 150w(최대전력 250w)

large power transient: 150w 급격한 감소(Drop), 130w 빠른 증가(Ramp)

c. 편차: 55w

1. NVIDIA RTX 4090 (w/ GPT-2 124M) _ 124M paramteters

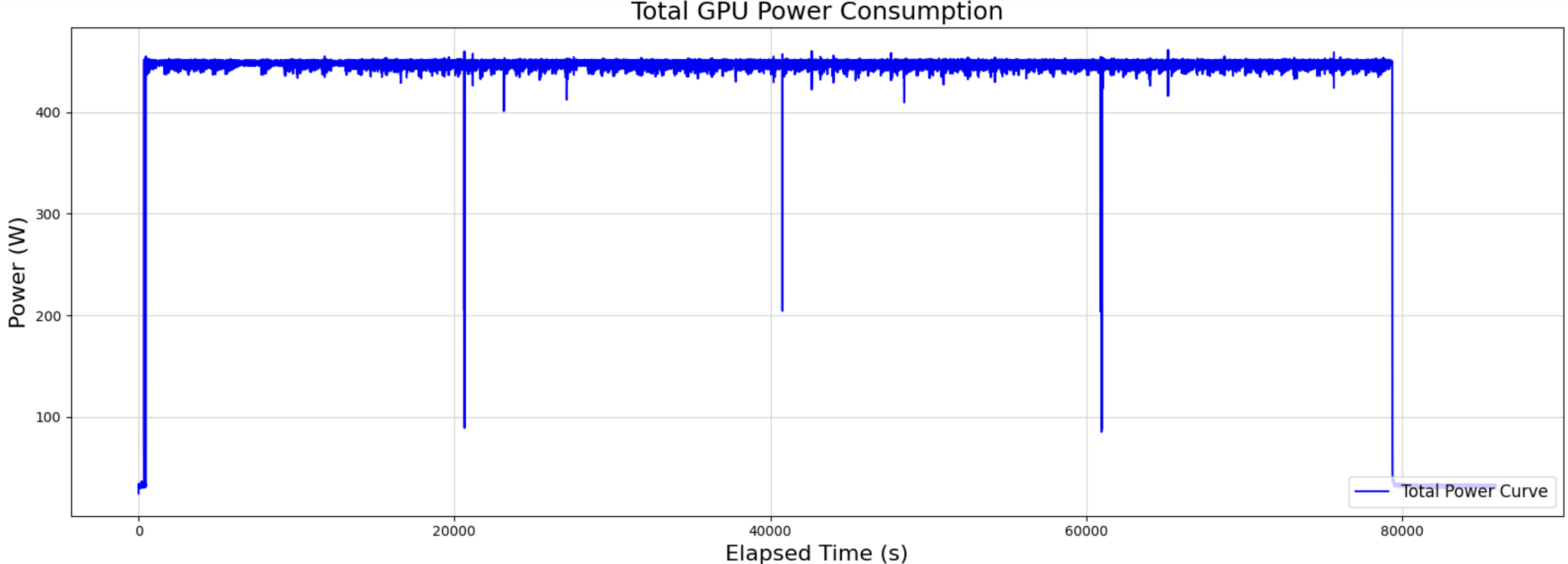

- Fig. 9번에서는 대부분 400 ~ 460w 구간을 보이나, 약 6시간 간격으로 +-350w 정도의 급락이 수 초만에 일어남 (급락 구간은 Check Point, 저장. 데이터 프리패치 등 I/O 병목으로 예상됨)

- Fig. 10번에서는 1초 내외의 짧은 시간에 순간 전력저하(200w) 및 전력증가(350w)를 보임

단일 GPU라도 1초 이내에 300w의 상의 급격한 변화가 발생 하여, UPS.ESS 설비는 1초 미안 응답 속도로 0.7 X TDP 정도의 headroom을 갖을 수 있도록 설계가 필요.

2. ADM RX 7900 XTX (w/ nanoGPT) _ 27M parameters

Fig. 11에서는 50 ~ 120W의 baseline과 250w의 Peak가 15 ~ 30초 간격으로 지속 반복됨. NVIDA (w/GPT-2) 대비 꼬리는 짧지만 중간 램프( 50 ~130w) 빈도가 두 배 이상을 보임

Fig. 12에서도 1초 내외의 시간에 150W로 급격한 감소(Drop), 200W의 급격한 상승(Ramp)이 나타나며 변동성이 큰 모습을 보임.

RTX 4090 + GPT-2 124M 조합은 고성능, 고전력, 안정적 소비를 보여주며, 냉각 및 전력 공급 설계가 중요하며,

RX 7900 XTX + nanoGPT 조합은 저전력, 높은 변동성을 보이며, 에너지 효율성과 유연한 자원 관리가 중요

'Data Center > Data Center' 카테고리의 다른 글

| AI Datacenter 에 필요한 Load(부하) 특성 _ Part 6_(LLM Inference) (0) | 2025.07.18 |

|---|---|

| AI Datacenter 에 필요한 Load(부하) 특성 _ Part 5_(Finetuning) (0) | 2025.07.15 |

| AI Datacenter 에 필요한 Load(부하) 특성 _ Part 3 (0) | 2025.07.07 |

| AI Data center 에 필요한 Load(부하) 특성 _ Part 2 (0) | 2025.07.05 |

| AI Data center 에 필요한 Load(부하) 특성 _ Part 1 (0) | 2025.07.03 |